Ollama本地部署llama3结合open-webui使用AI大模型——墨涩网

Llama 3是由Meta(Facebook) AI发布的一个开源语言模型系列,包括一个8B(十进制的80亿)模型和一个70B(十进制的700亿)模型。Llama 3支持多种商业和研究用途,并在多个行业标准测试中展示了其卓越的性能。

Llama 3采用了优化的自回归Transformer架构,这种架构专为处理复杂的文本生成任务设计,能够有效提升生成文本的连贯性和相关性。模型结合了监督式微调(SFT)和带人类反馈的强化学习(RLHF),这种混合方法不仅增强了模型的帮助性,也提高了安全性,使得模型在实际应用中更加可靠和符合用户预期。

一、安装ollama

ollama官网:https://ollama.com/

根据自己的系统类型下载Ollama

下载地址:https://ollama.com/download

下载以后直接双击运行安装即可,安装过程全部默认。

二、通过ollama下载AI模型

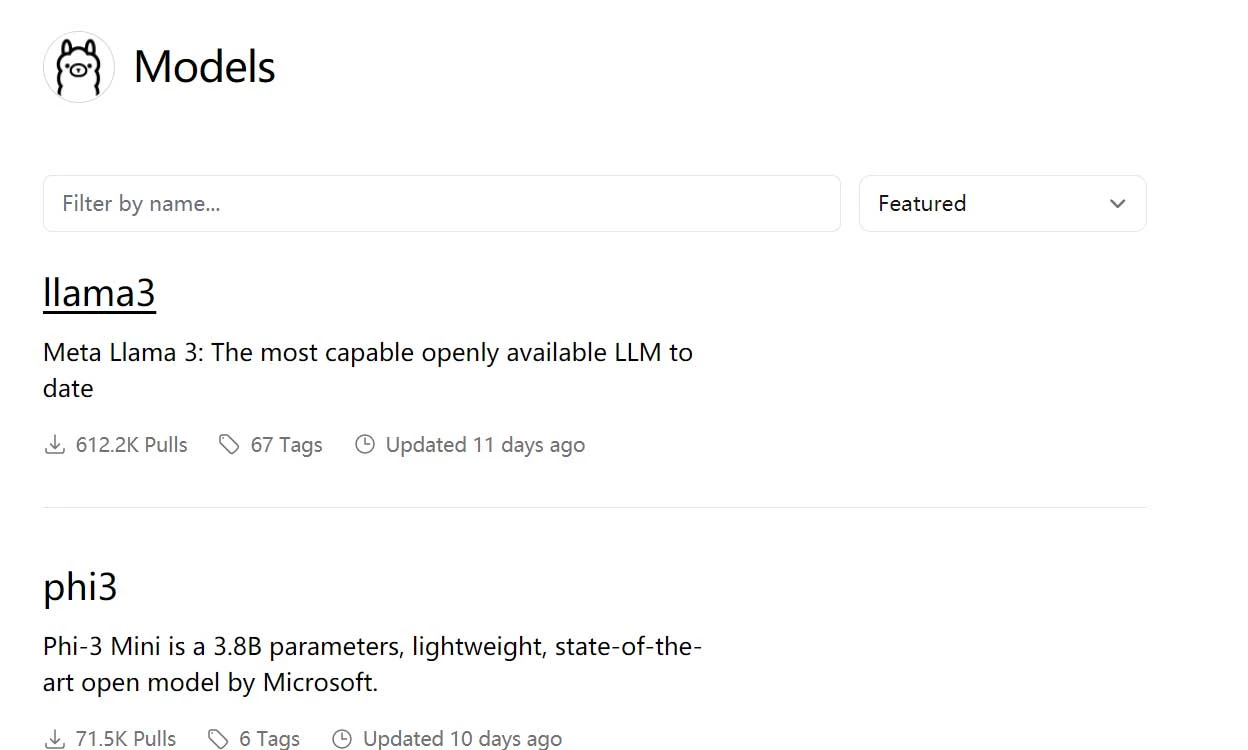

打开ollama的模型的网页:https://ollama.com/library

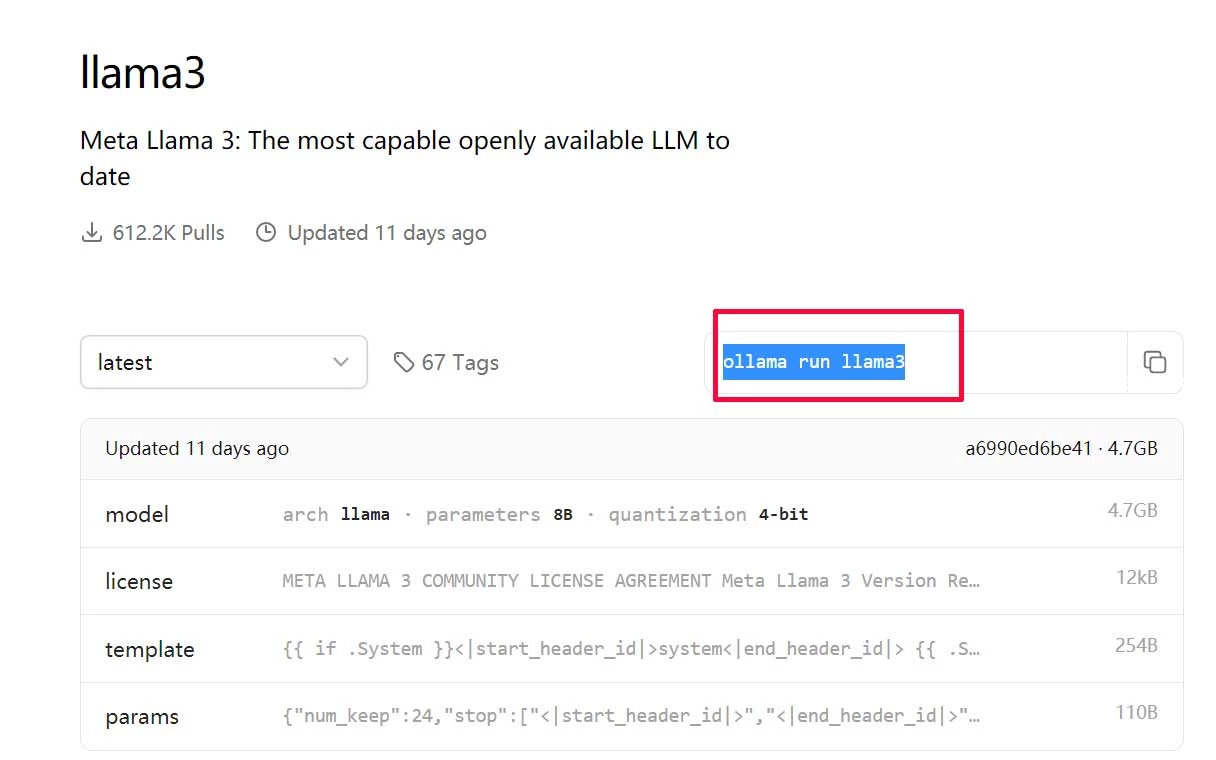

找到llama3,双击进入,复制安装命令(如果需要其他ai模型同理操作)

ollama run llama3

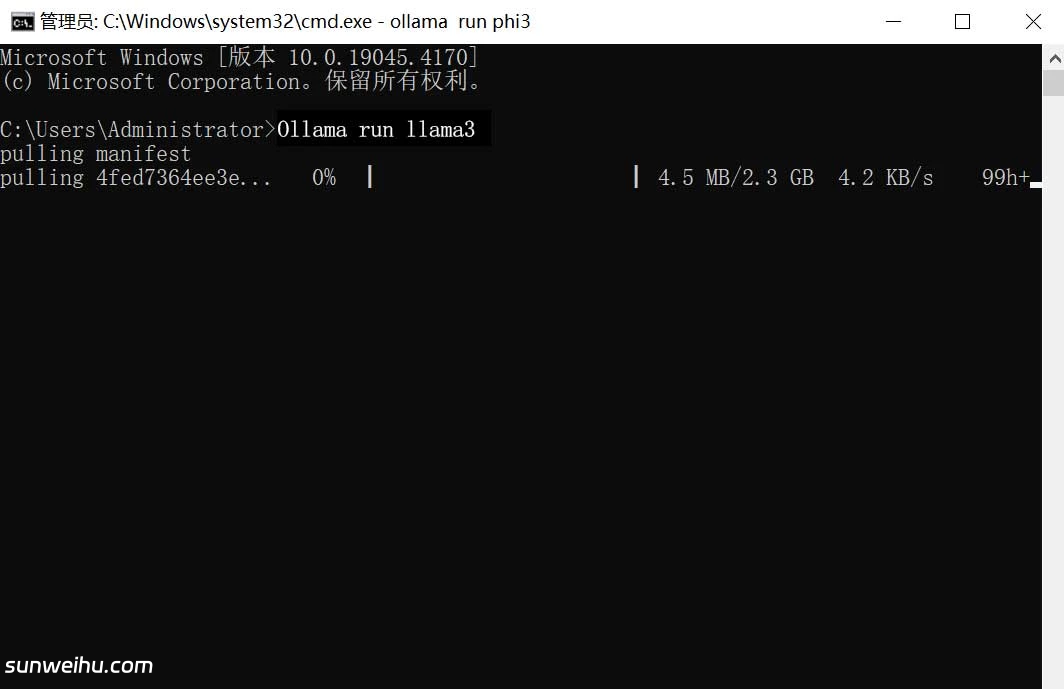

按下“win”+“R”,输入“cmd”回车,右键粘贴刚才的命令,再次回车开始下载安装llama3。

其他ollama常用的命令有

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

cp Copy a model

rm Remove a model

help Help about any command

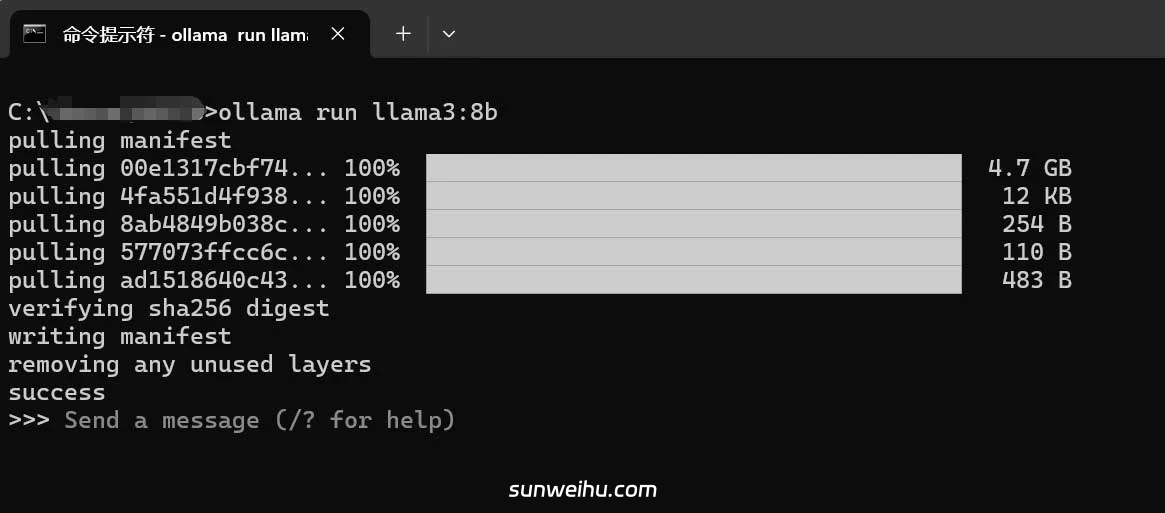

看到下面的提示就说明安装完成了,之后直接输入你需要的问题就可以开始对话了。

之后再次需要对话的时候再CMD命令行中输入ollama run llama3,就可以开启对话了。

这样在CMD命令行中使用ollama模型非常不方便,我需要安装结合open-webui或lobe-chat等开源免费的WEB界面使用。

三、open-webui下载安装使用

1.启动微软Hyper-V,打开“控制面板->程序->启用或关闭Windows功能”

-

勾选Hyper-V选项

-

重启电脑后安装成功

2.安装docker环境。

docker官网:https://docker.com/

下载docker desktop

下载地址:https://docs.docker.com/desktop/install/windows-install/

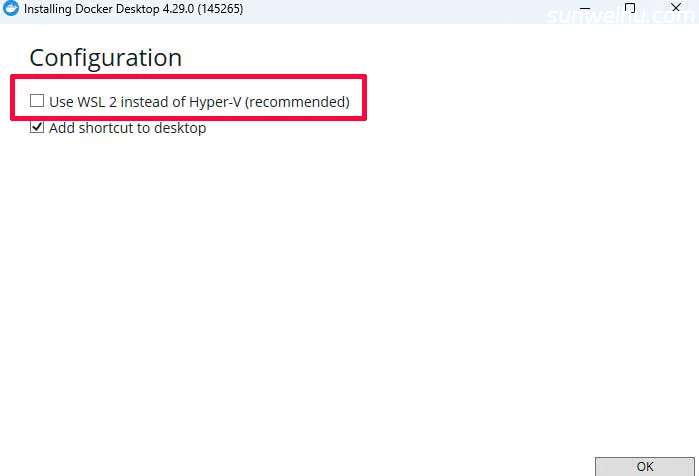

下载以后,直接双击运行exe文件,注意去掉“Use WSL2 instead of Hyper-V(recommended)”的勾选,否则会带来很多问题(踩坑的经验)。

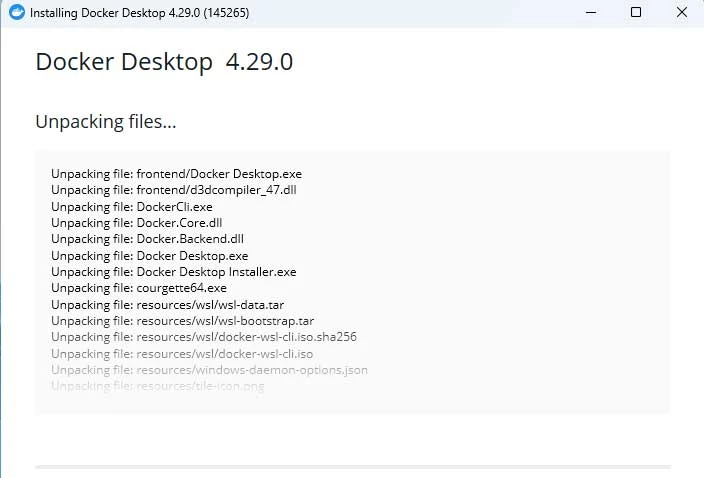

等待安装

安装完成,点击“Close and restart”重启计算机。

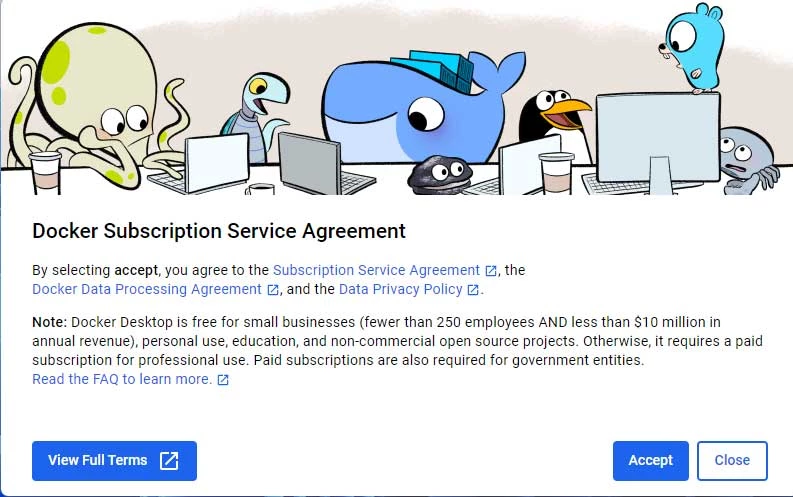

系统重启后。双击运行桌面的“Docker Desktop”图标,弹窗点击“Accept”。

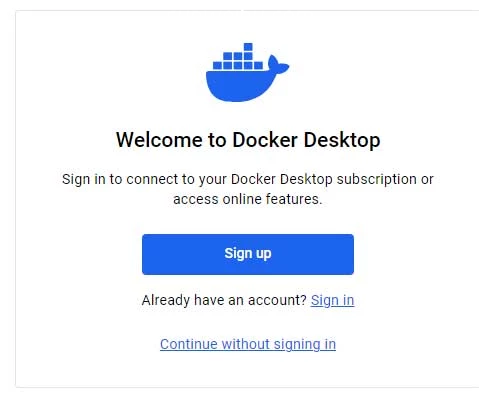

点击:“Continue without signing in”,不登录进入。

点击:“Skip survey”

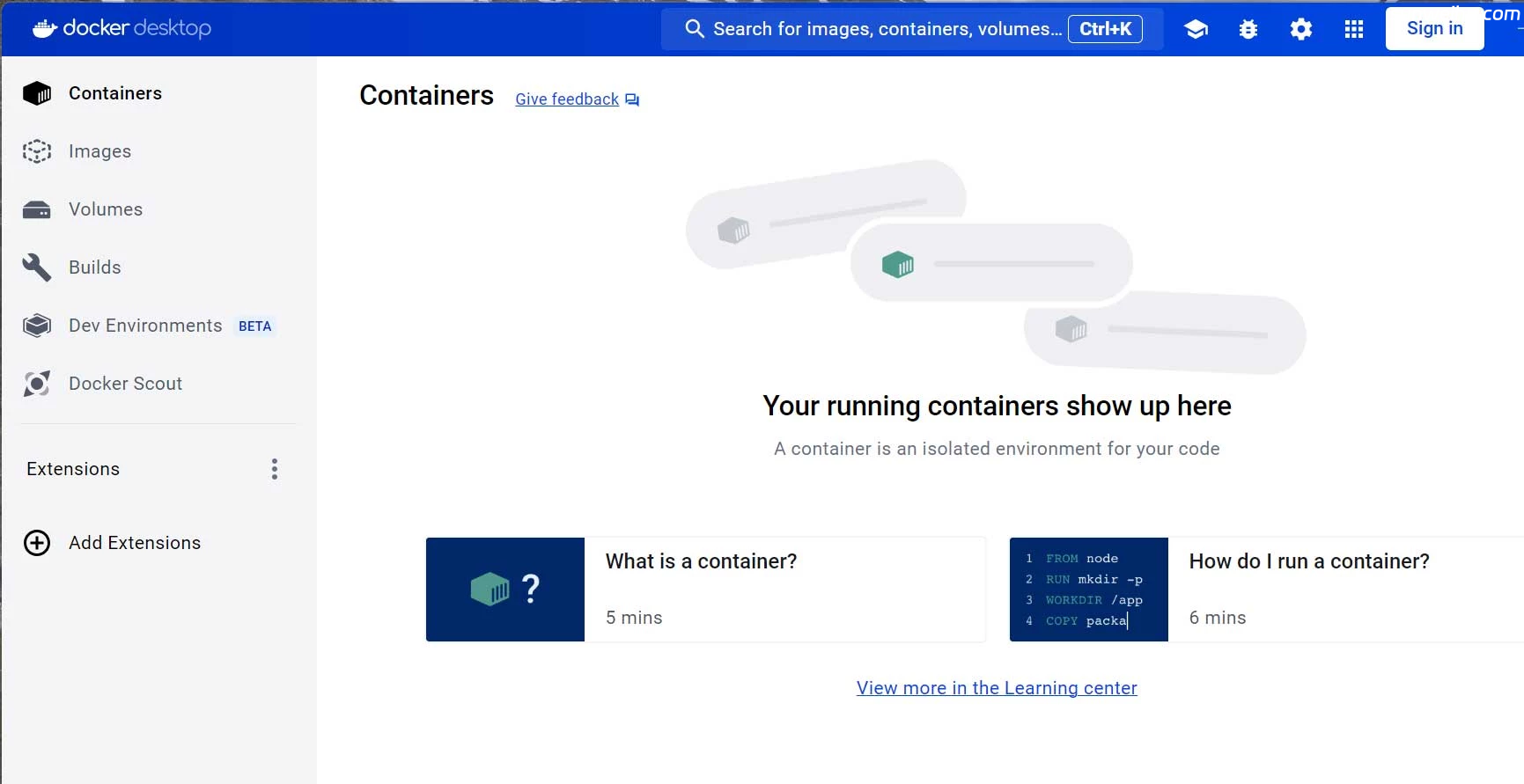

进入到了Docker Desktop界面。

切换国内源(设置⚙—Docker Engine),粘贴下面的内容,点击“Apply&restart”保存并重启Docker

{

"registry-mirrors": [

"https://82m9ar63.mirror.aliyuncs.com",

"http://hub-mirror.c.163.com",

"https://docker.mirrors.ustc.edu.cn"

],

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"features": {

"buildkit": true

}

}

3.Docker安装open-webui服务。

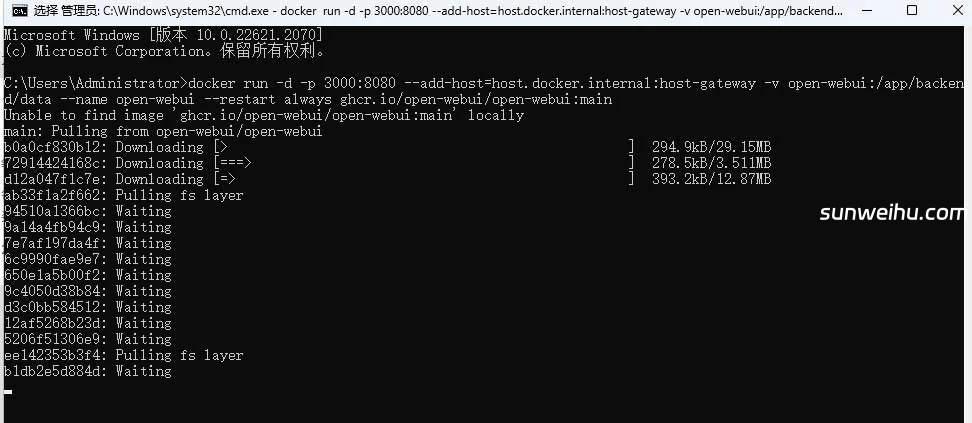

按下“win”+“R”,输入“cmd”回车,右键粘贴下面的命令,回车。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main这个安装过程根据你的网络环境情况,时间可能会比较长,请耐心等待,直到出现下面的界面。

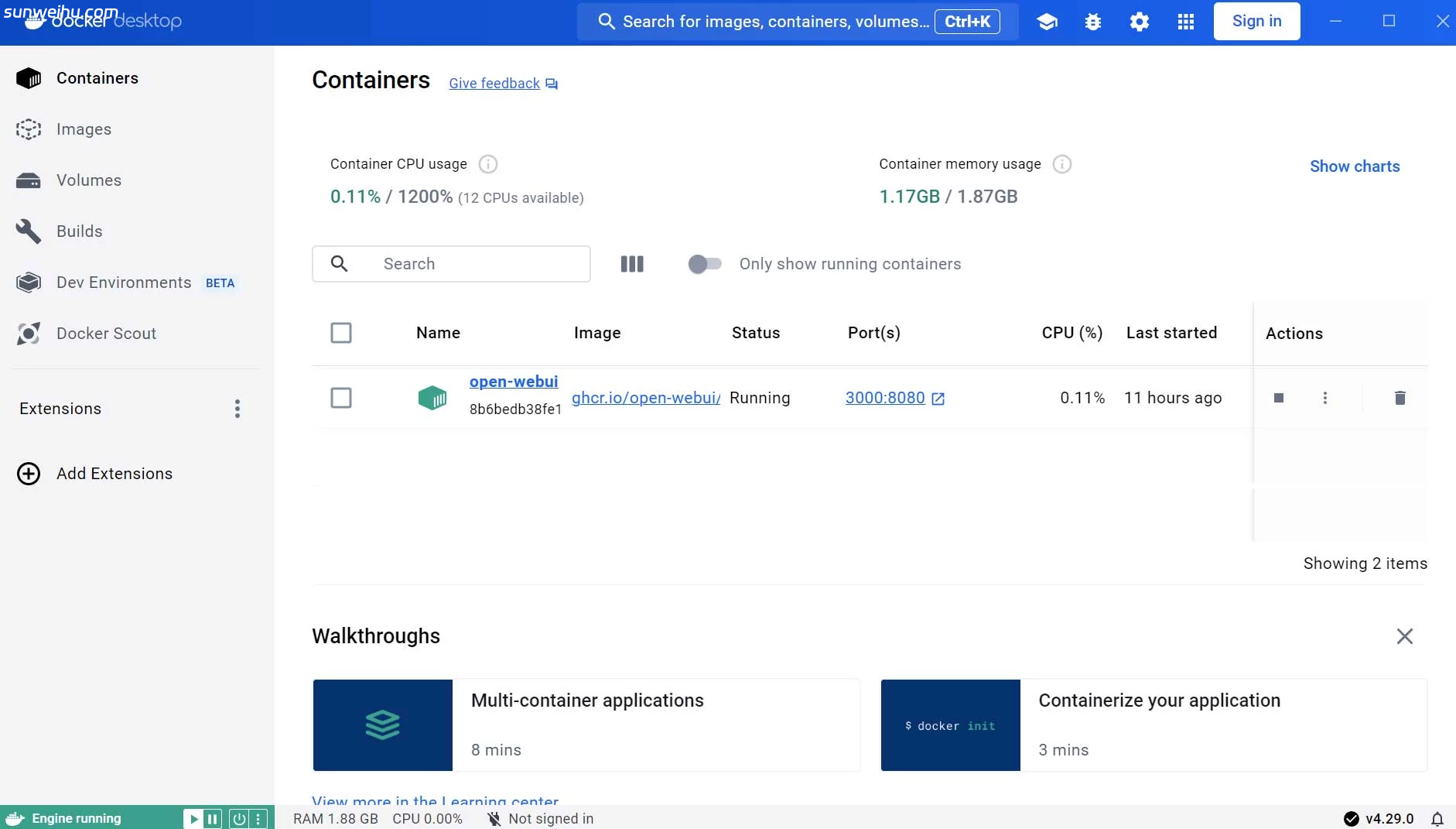

再次打开Docker Desktop界面,就可以看到已经在运行的open-webui服务。

点击“port(s)下面的端口号就可以大打开“open-webui服务”的网页了。

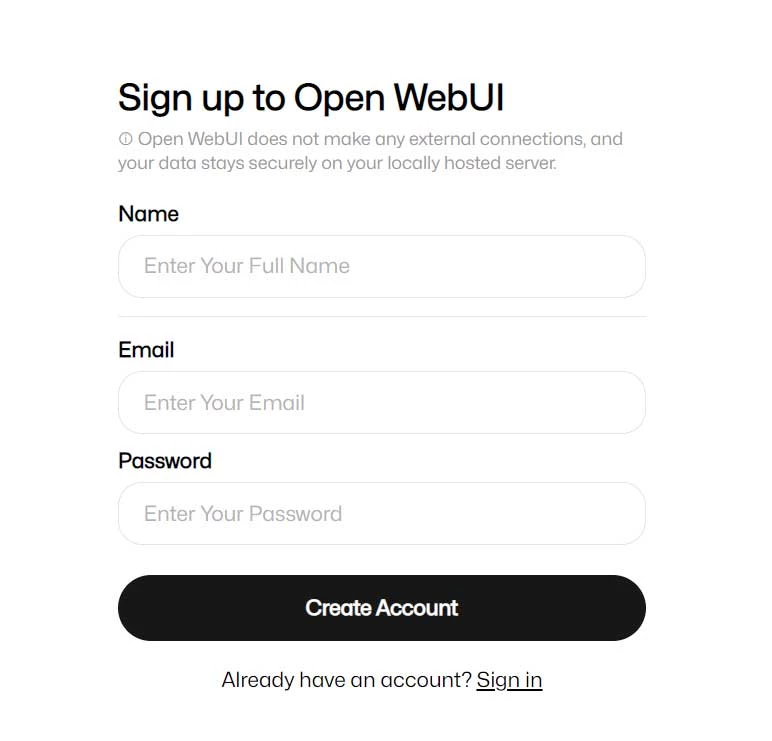

点击“Sign up”,打开注册页面,输入注册信息,点击“Create Account”,注册第一个注册的就是管理员。

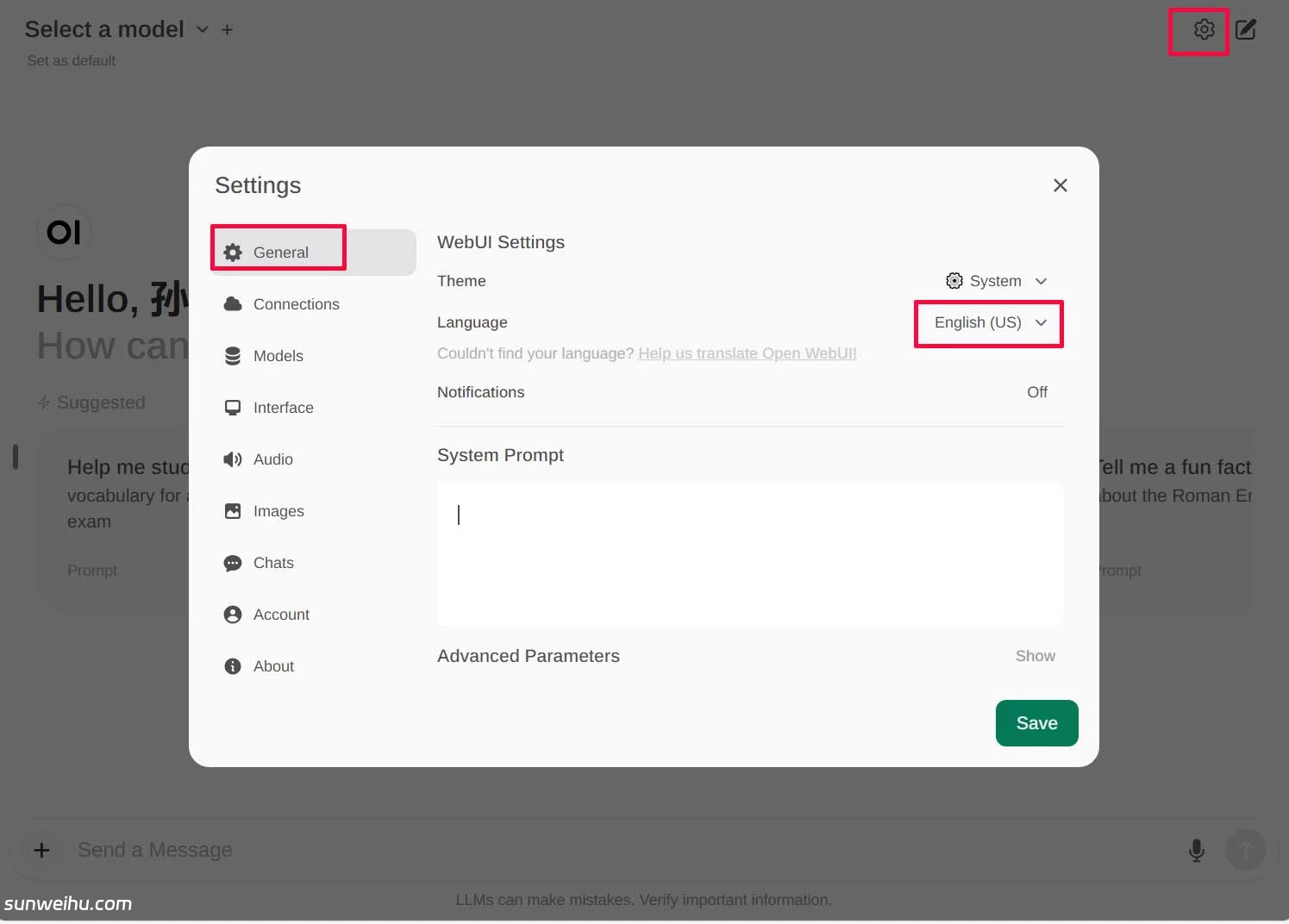

注册后完成,点击右上角的设置⚙——Geeral——Language,选择chinese即可切换中文。

之后可以看到直接可以选择之前部署好的llama3:8b模型,开始使用吧。

版权声明:本文采用知识共享 署名4.0国际许可协议BY-NC-SA 进行授权

文章作者:<墨涩>

文章链接:

免责声明:本站为资源分享站,所有资源信息均来自网络,您必须在下载后的24个小时之内从您的电脑中彻底删除上述内容;版权争议与本站无关,所有资源仅供学习参考研究目的,如果您访问和下载此文件,表示您同意只将此文件用于参考、学习而非其他用途,否则一切后果请您自行承担,如果您喜欢该程序,请支持正版软件,购买注册,得到更好的正版服务。

本站为非盈利性站点,并不贩卖软件,不存在任何商业目的及用途,网站会员捐赠是您喜欢本站而产生的赞助支持行为,仅为维持服务器的开支与维护,全凭自愿无任何强求。